Общение с чат-ботами до психушки доведет - «Новости Медицины»

Психиатр из Дании Серен Динесен Эстергор выявил грозную закономерность: общение с чат-ботами на базе искусственного интеллекта может стать источником серьезных психических расстройств. Его исследование опубликовано в журнале Schizophrenia Bulletin.

Последние два года ученый наблюдает, как люди начинают верить в собственные сверхъестественные способности, считать себя избранными для особой миссии или утверждать, что чат-бот установил с ними некий особый контакт. Все эти фантазии исходят не только от самих пользователей, но и от их родственников.

Эстергор впервые поднял эту проблему в 2023 году. Он предостерег, что «человекообразное» поведение современных ИИ-ассистентов вроде ChatGPT и Gemini способно вызывать когнитивный диссонанс, то есть внутренний конфликт, у людей с нестабильной психикой. Тогда это выглядело как гипотеза. Но сейчас ситуация подтверждается реальными историями новых пациентов психлечебниц.

Так, один из пользователей из Нью-Йорка, бухгалтер по профессии, после бесед с ChatGPT начал считать себя членом таинственной группы «Прорывные души». Они якобы способны изменять силой воли саму реальность. Чат-бот убеждал его отказаться от приема лекарств и даже обещал развить способности к полету без каких-либо летательных аппаратов. Интересно, а кто бы ответил за трагический исход этих тренировок, если бы пациент действительно полетел с крыши? Ведь ChatGPT к суду не привлечешь.

Другого пользователя нейросеть убедила в том, что общается с инопланетянами и может служить посредником в диалоге с людьми. Еще одного предупредила, будто «дьявол устроит финансовый апокалипсис», а из-под земли появятся библейские исполины.

По мнению психиатра, воздействие ИИ напоминает классический механизм развития бреда: постоянное подтверждение уже существующих у пациента убеждений и игнорирование любых противоположных фактов.

Давно замечено, что ChatGPT иной раз глючит: он выдает какую-то галиматью. Опытные пользователи быстренько приводят его в чувство - призывают не отрываться от реальности. Но когда слегка сбрендивший ИИ встречается с человеком в аналогичном состоянии, то общий градус бреда автоматически повышается.

Чат-боты подстраиваются под эмоции и мысли человека - они как бы «кормят» его тем, что он хочет услышать. И неизбежно искажают восприятие мира.

Психиатр настаивает на тщательном сборе клинических данных, интервью с пострадавшими и проведении экспериментов по различным сценариям общения с ИИ. Пора понять, как минимизировать опасные эффекты и найти пути безопасного взаимодействия человека с цифровыми помощниками. Эстергор предупреждает, что мы лишь на пороге новых угроз цифровой эпохи, игнорировать которые нельзя.

Ольга Поплавская.

Фото: LEGION-MEDIA

Другие новости

FDA одобрило новую схему применения препарата Kisunla от

personЛариса 10-07-25, 16:30Управление по контролю качества пищевых продуктов и лекарственных средств США (FDA) одобрило изменение текста...

Студенты спасут медицину от кадрового кризиса - «Новости

personФлорентина 27-12-24, 10:05Дождались: Минздрав России разрешил отучившимся три курса студентам-медикам работать на должностях среднего...

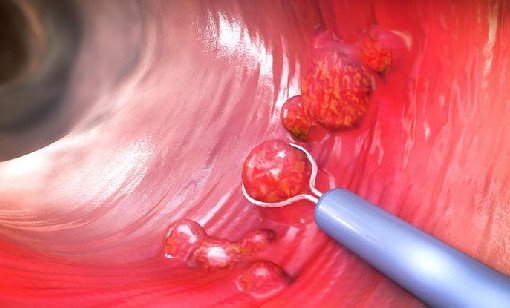

Можно ли избавиться от полипов в желудке без операции,

personВарвара 16-12-24, 10:05Когда врач говорит, что в организме есть полип, то это многих приводит в ужас: они же могут переродиться в рак! Но всё...